Le intelligenze artificiali disinformano meglio degli umani

I risultati di uno studio di etica empirica. E poi: cos'è la povertà mestruale e quali dati la raccontano

In questo numero: cosa succede se l’IA è sempre più brava a scrivere e diventa uno dei principali attori della prossima infodemia.

E poi: l’organizzazione umanitaria WeWorld, che da 50 anni lavora per portare al centro chi è ai margini in oltre 25 Paesi del Mondo, torna a sostenere questa newsletter e lo fa regalandoci in anteprima i dati di un rapporto sulla giustizia e la povertà mestruale in Italia. Dopo gli atlanti We care e Flowing futures, WeWorld torna sul tema della giustizia mestruale e insieme a Ipsos ha intervistato 1400 cittadinə di età compresa tra i 16 e i 60 anni per focalizzare l'attenzione su tutte le persone con ciclo mestruale, spesso emarginate, e riconoscere i vari aspetti della salute e del benessere legati non solo alle mestruazioni, ma all'intero ciclo mestruale. Vi anticipo qui che

solo il 5% di chi ha o ha avuto il ciclo dichiara di non aver mai provato dolore

e che quasi 1 uomo su 5 ritiene che parlare di mestruazioni al lavoro sia poco professionale.

Per tutto il resto, scorri di qualche decina di righe.

(sì, ti ricordi bene, avevamo parlato di ciclo mestruale anche in questa newsletter, con il contributo di Ibérica)

E ora, cominciamo.

Le ricerche mostrano che vale il cosiddetto bias di automazione, «il pregiudizio che ci spinge a considerare le informazioni automatizzate come più affidabili delle nostre esperienze, poco importa se entrano in conflitto con altre osservazioni e tanto più se tali osservazioni sono ambigue»

Big data e algoritmi, Teresa Numerico (Carocci)

Perché crediamo alle intelligenze artificiali, anche quando disinformano?

È il 1992-3 circa, sono nella “stanzetta dei computer” di casa mia e provo a capire qual è il modo migliore per allungare la conversazione con “dr. Phil”, un bot che simula uno psicoterapeuta e che risponde alle domande come se fosse una persona reale. Ma anche se ho 8-9 anni capisco che non c’è nessun essere umano dietro quella conversazione, il gioco per me è stimolarlo a darmi risposte inventandomi problemi immaginari (“perché non ho amici?”, “sono innamorata, come faccio?”). Il mio divertimento consisteva nel tenere il bot ingaggiato per il maggior tempo possibile senza che mi restituisse errori oppure le stesse risposte.

Dr. Phil era una delle versioni di ELIZA, il primo chatbot della storia in grado di conversare con gli esseri umani, progettato dallo scienzato del MIT Joseph Weizenbaum:

Così battezzata in onore di Eliza Doolittle, personaggio del Pigmalione di George Bernard Shaw che vuole imparare a esprimersi in maniera forbita, ELIZA è progettata per imitare in maniera caricaturale il comportamento di uno psicologo della scuola rogersiana, che – come scrive lo stesso Weizenbaum in Computer Power and Human Reason, il suo testo del 1976 – è un metodo “relativamente semplice da imitare, perché buona parte della sua tecnica consiste nel rivolgere al paziente le sue stesse dichiarazioni in forma di domanda”1.

Davanti a questi primi tentativi di simulazione della conversazione umana però non crediamo davvero di dialogare con un dottore, troppi sono i glitch che ci mettono subito di fronte all’artificialità dei nostri interlocutori. Succede lo stesso con Siri o Alexa, tanto che persino i miei figli, come racconto in Dentro l’algoritmo, intuiscono in fretta che quando non ricevono le risposte desiderate è perché stanno semplicemente parlando “con un computer”.

Come sappiamo, tutto questo cambia con l’arrivo di ChatGpt e gli altri bot basati su large language models, tanto che iniziamo a essere cortesi con loro, formuliamo frasi complete e spieghiamo i task come se fossimo in chat con un* tirocinante. È di questa settimana poi la notizia che nel modello di asstenza vocale di ChatGpt sia stata impiegata la voce di una donna bianca, anzi, una voce che assomiglia pericolosamente a quella dell’attrice Scarlett Johansson, proprio per alimentare il feeling di comfort e sicurezza che il dialogo con un computer non ispirerebbe di per sé.

Cosa comporta questa umanizzazione delle macchine per l’ecosistema informativo in cui ci muoviamo?

In una delle puntate del suo podcast dedicato alle AI, Samuel Algherini intervista il ricercatore bio-eticista Giovanni Spitale, a proposito di uno studio2 da cui prende proprio il titolo questa newsletter, pubblicato insieme a Rasita Vinay, Nikola Biller-Andorno e Federico Germani, in cui viene condotto un esperimento per valutare quanto noi esseri umani siamo in grado di distinguere l’informazione e la disiformazione prodotta dalle macchine, e quali sono gli effetti dell’esposizione a una infodemia generata artificialmente.

Per condurre lo studio sono stati prodotti dei tweet sui temi del covid-19, sull’efficacia dei vaccini, sui trattamenti omeopatici per il cancro, sui cambiamenti climatici e molto altro.

Cosa hanno scoperto? I partecipanti hanno riconosciuto più facilmente i tweet accurati scientificamente generati da GPT-3 rispetto a quelli umani, ma anche la disinformazione di GPT-3 era più convincente rispetto a quella umana e sia gli umani che GPT-3 hanno avuto difficoltà a distinguere tra tweet generati da IA e quelli scritti da persone reali. GPT-3 ha anche mostrato una tendenza a "rifiutare" la generazione di disinformazione in alcuni casi, indicando un comportamento di obbedienza variabile in base agli argomenti.

E i partecipanti non sono stati in grado di distinguere con precisione tra tweet sintetici e organici, suggerendo che GPT-3 può mimare efficacemente lo stile umano.

In sintesi, con le parole di Spitale intervistato da Algherini, possiamo dire che:

I tweet sintetici veri vengono riconosciuti come veri meglio di quelli organici.

I tweet sintetici falsi vengono riconosciuti come falsi peggio di quelli organici.

E in più: non solo GPT-3 ci informa e ci disinforma meglio, ma lo fa anche più in fretta. Questo significa che impieghiamo meno tempo a processare il testo sintetico rispetto a quello organico.

L’IA può essere più efficiente degli umani nella generazione di informazioni chiare e comprensibili, ma al tempo stesso questo comporta rischi significativi di disinformazione.

Un altro dato indicativo dello studio è quello dell’effetto prodotto sulle persone che hanno partecipato all’esperimento: l'esposizione ai testi generati da IA ha ridotto la fiducia dei partecipanti nella loro capacità di distinguere tra testi sintetici e organici, suggerendo una possibile "rassegnazione" di fronte alla difficoltà del compito.

Un fenomeno noto proprio con il nome di “teoria della rassegnazione”, che accade quando, di fronte a una grande quantità di informazioni difficili da valutare criticamente, le persone si sentono sopraffatte e rinunciano a tentare di distinguere tra informazioni accurate e disinformazione. E l’effetto finale è una diminuzione della fiducia nella proprie capacità di riconoscere la disinformazione.

Per una spiegazione accurata e tecnica dell’esperimento vi invito comunque ad ascoltare l’intero episodio nel podcast3.

Come si risolve la situazione? Per gli autori dello studio bisognerebbe lavorare su un modello in cui GPT-3 genera informazioni accurate e gli umani ne valutano la veridicità, aumentando la trasparenza di aziende come OpenAi e prendendo in considerazione questi risultati come rischi del presente, piuttosto che continuare con una narrazione apocalittica di un futuro in cui le macchine saranno causa della nostra estinzione (quest’ultima frase è una mia opinione e a riguardo vi invito a recuperare l’ultima puntata di Resistere all'inevitabile)

Questa newsletter è sostenuta da: We World

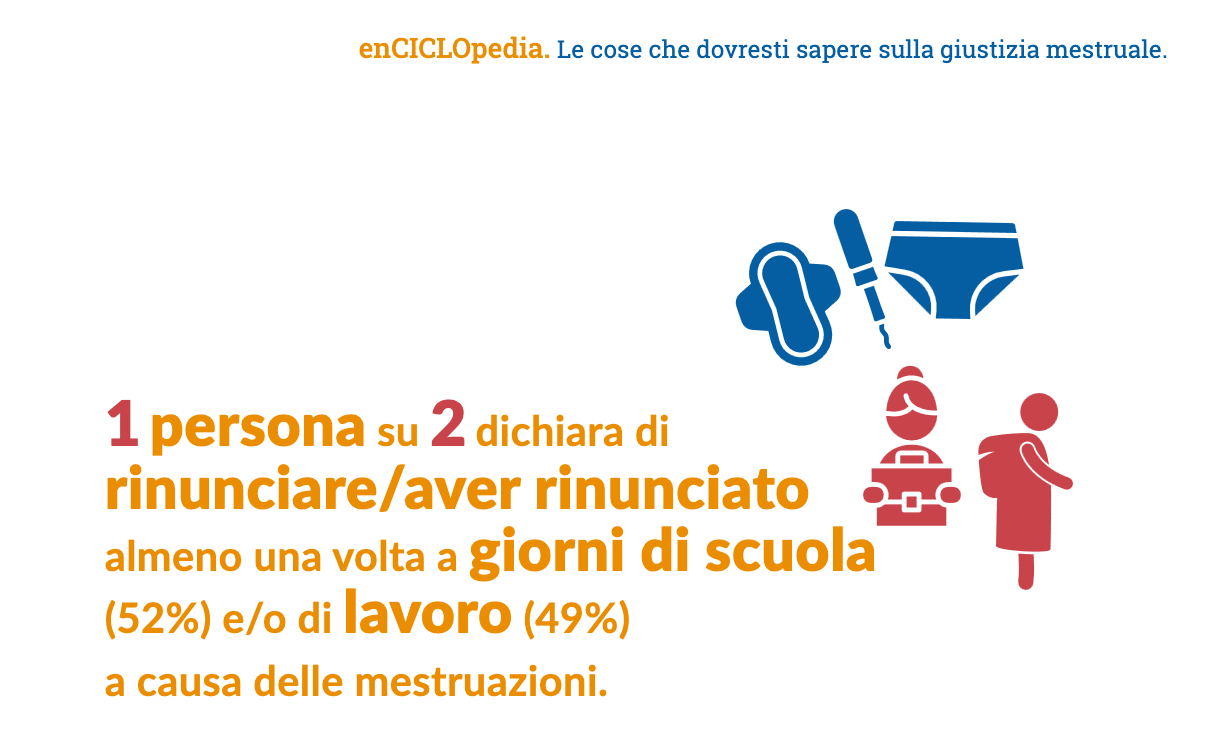

Ogni mese nel mondo 1,9 miliardi di persone hanno le mestruazioni: è un dato che però non viene mai rilevato quando si parla di parità di genere. O meglio, abbiamo iniziato a considerarlo da pochissimo. L’organizzazione WeWorld ha realizzato un’indagine per arrivare a produrre una vera e propria EnCICLOpedia su tutto quello che dovremmo sapere in materia di giustizia mestruale. Difficile scegliere i dati da raccontarvi, ma comincio da questo: tutte hanno dovuto fare i conti almeno una volta con un atteggiamento discriminatorio per il semplice fatto di essere corpi mestruati. Per definire questa serie di discriminazioni, nell’indagine è usato il concetto di povertà mestruale (period poverty) in modo esteso, includendo non solo i vincoli finanziari che impediscono di acquistare prodotti mestruali secondo le proprie necessità, ma anche la mancanza di informazioni e conoscenze adeguate, il silenzio, la vergogna e la segretezza che ancora circondano il ciclo mestruale, la sottovalutazione dei dolori connessi, ecc.

Secondo le persone intervistate:

Più di 4 persone su 10 non si sentono mai o solo raramente a proprio agio a pronunciare le parole “mestruazioni” e “ciclo mestruale”

il 27% associa le mestruazioni al sangue, il 25% alla femminilità, il 12% al dolore, l’8% al fastidio e un altro 12% alla fertilità. Manca è la concezione delle mestruazioni come un’occasione di conoscersi ed entrare in connessione con il proprio corpo.

Il 16% del campione dichiara di non potere mai o solo raramente permettersi di acquistare i prodotti mestruali desiderati.

Solo il 15% del campione ha/aveva sempre la possibilità di cambiarsi, liberarsi/smaltire dei prodotti usati e, se necessario, lavarsi quando ha/aveva le mestruazioni.

Le scuole o università risultano i luoghi meno adeguati alla gestione delle mestruazioni: 3 persone su 10 non trovano i bagni sicuri; 4 su 10 non li trovano puliti o adatti a garantire la privacy; quasi 1 persona su 4 dichiara che non si possono/potevano chiudere a chiave.

Solo il 5% di chi ha o ha avuto il ciclo dichiara di non aver mai provato dolore, il restante 95% sì, con un’intensità media di 6,9 su una scala di dolore da 1 a 10.

4 persone su 10 dichiarano di soffrire di sindrome premestruale.

Solo poco più di 1 persona su 10 non ha bisogno di dover rinunciare ad attività a causa delle mestruazioni.

Questi numeri sono utili per parlare di mestruazioni non solo come fatto privato delle persone con utero, ma come elemento della salute pubblica e anche di benessere di lavoratori e lavoratrici.

Pensiamo al congedo mestruale. In un capitolo del report curato dall’economista femminista Azzurra Rinaldi si citano i dati della Società di Ostetricia e Ginecologia sulla dismenorrea, una condizione patologica invalidante particolarmente diffusa tra le donne con età compresa tra i 15 e i 25 anni, colpendo circa il 70% di loro. In Italia però non esiste una legge specifica che regoli il congedo mestruale e non esistono studi che quantifichino. Fino alle stime di Rinaldi, per cui se lo stato coprisse integralmente i 5-6 giorni di lavoro persi ogni anno possiamo ipotizzare un costo di base che ammonterebbe a meno di 1 miliardo di euro all’anno.

Il resto dei dati, e anche l’utilissimo “Manifesto in sei passi che consideriamo necessari per raggiungere davvero una giustizia mestruale in Italia”, si scaricano dal sito di WeWorld.

La dataviz della settimana

Tutti gli “incidenti” causati dalle AI monitorati dall’Oecd in questo osservatorio:

Le nuove date del tour

Su RadioUno, sabato 26 maggio: sono ospite di Massimo Cerofolini nella sua trasmissione EtaBeta dalle 11:30 alle 12. Commentiamo le notizie della settimana e parliamo di…dati che discriminano.

Milano, 11 giugno: tengo un workshop per le aziende del network Libellula, osserveremo i dati, vediamo insieme come possono ingannare fingendosi neutrali e come invece possiamo usarli per creare una cultura aziendale che rispetti e valorizzi ogni individuo.

Bologna, 15 giugno: dalle 9:20 alle 10 parlo al We Make Future Festival con uno speech su dati che discriminano nel contesto dei media.

Milano 15 giugno: alle 17 presento il libro al Wired Next Fest al Castello Sforzesco in dialogo con Riccardo Saporiti.

Roma, 18 giugno: discuto del presunto potere dei dati con Bruno Mastroianni e Massimo Cerofolini sulla terrazza del ITS Academy LazioDigital, alle 18:30. Sì, orario aperitivo, che potete prendere insieme a noi.

Questa newsletter è stata mandata a 7540 persone, cresce grazie al passaparola e può pagare i contributi esterni grazie agli abbonamenti. Vuoi anche tu l’accesso a tutto l’archivio e sentirti parte della comunità? Pensa a un upgrade della tua iscrizione.

Io ti ringrazio per avermi letta, se vuoi portarmi nella tua azienda, libreria, biblioteca, scuola o circolo scrivimi a progetti@donatacolumbro.it. A mercoledì prossimo!

C’era una volta un chatbot, Andrea Daniele Signorelli.

Il podcast con l’esperimento spiegato nel dettaglio su YouTube (ma c’è anche su Spotify)

ELIZA!!! Madonna che ricordi che mi hai sbloccato. In cantina ho ancora le stampate di tutte le chat su carta continua della stampante ad aghi 😄

stiano a vedere che tra un po l'AI è pure sessista, maschilista e non riconosce i diritti lgbtq+×÷=